首页 > 教程

Langchain 教程-文档检索

- 2025-05-06

- 1171 ℃

一、核心概念:文档检索器的定位与作用

1.流程闭环:

文档加载(Loader)->文档分割(Splitter)→>**文档检索(Retriever)**>大模型交互

核心目标:从海量文档块中快速定位与用户问题最相关的内容,解决“大模型如何高效访问文档”的问题。

2.技术本质:

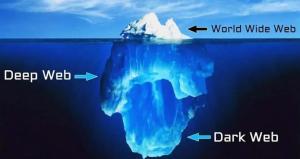

通过**向量数据库(Vector Store)**存储文档块的向量表示(词嵌入),利用向量相似度计算(如余弦相似度)实现语义检索。

二、核心组件与工作流程

3.三大核心组件:

嵌入模型( EmbeddingModel):将文档块转换为高维向量( 如OpenAl Embeddings、Hugging Face 模型);

向量数据库(如FAISS、Pinecone):存储向量并支持高效近邻搜索;

检索器(Retriever):封装检索逻辑,通过get_relevant _documents()返回相关文档块,

4.标准化流程:

#1.加载并分割文档(前序步骤)

from langchain.document loaders import TextLoadel

from langchain.text_splitter import RecursiveCharacterTextSplitter

loader = TextLoader("西游记,txt')

docs = loader.load()

text_splitter =RecursiveCharacterTextSplitter(chunk size=500)

split_docs =text_splitter.split_documents(docs)#2.初始化向量数据库与检索器

from langchain.vectorstores import FAlSS from langchain.embeddings import OpenAlEmbeddings embeddings=OpenAlEmbeddings0 db=FAlSS.from_documents(split_docs, embeddings) retriever=db.as_retriever0) # 默认可检索最相关的1个文档

#3. 执行检索

query="孙悟空是怎么诞生的?" relevant docs=retriever.get relevant documents(query)

三、关键参数与优化点

5.检索参数k:

控制返回的相关文档数量(如k=3 返回最相关的3个块)需根据模型上下文长度调整(避免超过 Token 限制 )。

6.向量数据库对比:

| 数据库 | 优势 | 适用场景 | 部署方式 |

| FAISS | 本地高效搜索,轻量级 | 小规模数据、离线场景 | 本地安装 |

| Pinecone | 分布式、高吞吐量 | 大规模数据、云端应多 | 云端 AP1/托管 |

| Chroma | 支持持久化存储,易集成 | 原型开发、中小规模 | 本地/云端均可 |

四、核心价值与应用场景

7.RAG(检索增强生成)核心环节:

解决大模型“幻觉”问题:通过检索真实文档信息,确保回答基于事实;

支持长文档问答:将用户问题映射到文档块,避免直接处理全量内容。

8.典型场景:

企业知识库问答(如客服机器人);

学术文献分析(快速定位相关章节);

法律合同审查(检索条款匹配度)。

A 提示栏(Cues/Questions)

| 笔记要点 | 复习提示问题 |

| 文档检索器的核心功能 | 为什么说检索器是文档与大模型交互的“中间人”?它解决了什么问题? |

| 向量数据库的作用 | 为什么需要将文档转换为向量存储?向量数据库如何实现高效检索? |

| 检索器初始化流程 | 简述从文档加载到检索器初始化的完整代码流程(包含加载、分割、嵌入、存储步骤)。 |

| 检索参数k的影响 | k值过大或过小会对检索结果产生什么影响?如何根据模型上下文调整? |

| 不同向量数据库的适用场景 | FAISS 和 Pinecone 分别适合什么场景?本地部署优先选哪个? |

B 总结栏(Summary)

本本文聚焦 LangChain 中文档检索器的核心原理与实践应用,核心内容如下:

1.技术定位:

作为 RAG 流程的关键环节,连接“预处理后的文档块”与“大模型”,实现基于语义的高效信息检索。

2.核心逻辑:

向量化:通过嵌入模型将文档块转换为向量,解决计算机“理解”文本的问题;

近邻搜索:向量数据库通过计算余弦相似度,快速返回与用户问题最相关的文档块(如k=1返回最相关的1个块)实战要点:3.

参数调优:根据模型上下文长度设置k值(如GPT-4 建议k≤5 以避免 Token 超限);

数据库选择:小规模数据优先本地部署FAISS,大规模或云端场景选 Pinecone/Chroma。

4.价值延伸:

检索器是解决大模型“数据边界”问题的关键--让模型具备动态访问外部知识的能力,而非依赖固定训练数据。核心意义:文档检索器是构建智能问答系统、知识库应用的核心组件,掌握其原理与实践是从“基础操作”进阶到“复杂场景开发”的重要标志。

相关内容

重症急性胰腺炎诊治指南

重症急性胰腺炎诊治指南 微信开放平台第三方申请

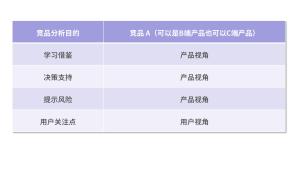

微信开放平台第三方申请 你选择产品视角还是用户...

你选择产品视角还是用户... 什么是Web 3.0 ?

什么是Web 3.0 ? 2025年8款免费且好用的图...

2025年8款免费且好用的图... splice变相跳出forEach循环

splice变相跳出forEach循环 PHP判断URL的合法性字符...

PHP判断URL的合法性字符... 移动硬盘打不开千万别格式化

移动硬盘打不开千万别格式化

-

坐骨股骨撞击综合征的MRI诊断价值研究

2024-06-18 1315

-

云计算在电子商务和零售业中的优势

2024-04-24 1200

-

Wireshark - 网络抓包工具截取并分析各种网络数据包

2025-06-16 1082

-

php常用文件操作函数方法

2021-07-27 1124

-

如何给你的产品做减法

2024-05-29 1296

-

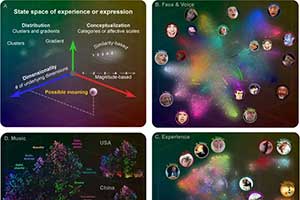

有人情味的Hume AI 会测谎会生气的人工智能

2024-07-17 1508

-

如何收集竞争对手的信息?

2024-05-29 1130

-

Nginx域名跳转 www跳转和不带www

2024-04-23 1627

-

微信设置电子监护人,杜绝渣男

2025-06-22 1427

-

微信错过群里抢红包怎么办?

2025-06-22 1324

文章评论 (0)

- 这篇文章还没有收到评论,赶紧来抢沙发吧~

进入有缘空间

进入有缘空间 点击分享文章

点击分享文章